Eva Wolfangel

das bin ich

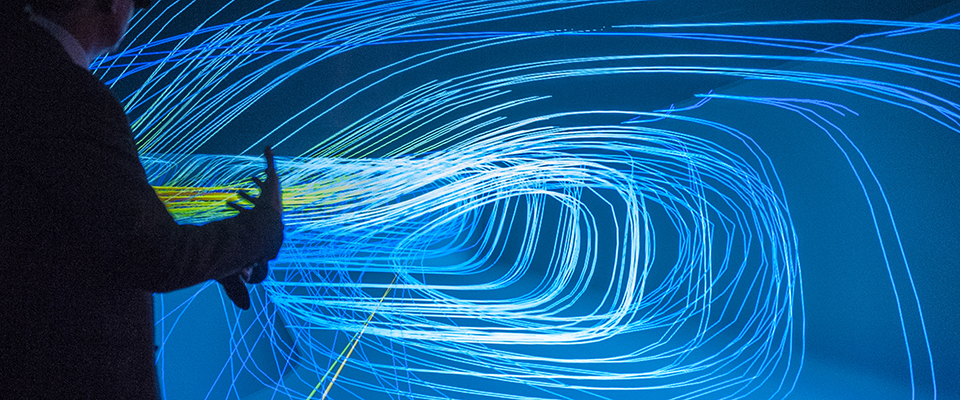

Ich begleite Goldschürferinnen in Uganda ebenso wie kalifornische Digital-Pioniere in der Virtuellen Realität oder Roboter-Forscher in Tokio und lasse mein Publikum als Reporterin und Speakerin daran teilhaben.

Wie leben wir in Zukunft? Das ist eine meiner Leitfragen, für die ich mich seit vielen Jahren mit Zukunftstechnologien wie künstlicher Intelligenz und virtueller Realität beschäftige. Ich schreibe für die meisten großen Magazine und Zeitungen in Deutschland und der Schweiz sowie für einige Englischsprachige. Zudem moderiere ich leidenschaftlich gerne Panels rund um das Thema Digitalisierung.

Journalistin

Speakerin

Highlights und Preise

Bereits 2008 hat mir eine Jury eine besondere Begabung darin bestätigt, komplexe technische Themen so aufzuschreiben, dass sie gerne gelesen wird: damals habe ich den Journalistenpreis Luft- und Raumfahrt gewonnen. Das hat mich ermutigt, diese Herausforderung weiter zu verfolgen - und es folgten weitere Auszeichnungen.